Forum | 02. Mai 2022

Kulturdaten und Datenqualität – offen über Probleme sprechen

Qualitätskontrolle, VEB Robotron Elektronik, Dresden 1976

CC BY-SA-3.0 Autor:in: Ulrich Häßler, Besitzer:in: Bundesarchiv

Am 2.5.2022 lädt das Team Datenstandards und Datenqualität (Task Area 2) des Konsortiums NFDI4Culture von 10:00 bis 15:00 Uhr zu seiner zweiten öffentlichen, digitalen Forumsveranstaltung ein. Diesmal stehen häufig auftretende Probleme und Fragen rund um das Thema Datenqualität im Kontext der Forschung im Fokus. Ausgangspunkt sind konkrete Szenarien in Projekten und Anwendungen aus der Kunst-, Musik-, Medien und Theaterwissenschaft. Der gewünschte gemeinsame Austausch bei der Veranstaltung soll dafür sensibilisieren, an welchen Stellen Probleme mit Datenqualität entstehen und wie man sie angehen kann.

Die Sicherung von Datenqualität ist ein Grundwert guter wissenschaftlicher Praxis, wobei die konkreten Qualitätsanforderungen von den wissenschaftlichen Fachgemeinschaften idealerweise selbst gesetzt und kontrolliert werden. Sind die Definition, Umsetzung, Überprüfung und Verbesserung der Datenqualität eine permanente Aufgabe, so stellen sie sich in zeitlich und finanziell begrenzten Projektvorhaben als besondere Herausforderung dar. Mit einem Blick auf die Werkbänke digitalen kulturwissenschaftlichen Arbeitens aus der Perspektive konkreter Projekte werden Akteur:innen über diese Herausforderungen und ihre Lösungsansätze berichten, wobei das Spektrum von der Datenqualität bei der Erfassung über den Einsatz von Normdaten, der (Weiter-)Entwicklung von geeigneten Vokabularen und Datenmodellen bis hin zu Verfahren des Datenmappings reicht. Daraus abgeleitet sollen Aspekte einer sinnvollen Qualitätskontrolle sowie eines über einzelne Projekte hinausgehenden auch institutionell verankerten Qualitätsmanagements und die dafür notwendigen strukturellen Rahmenbedingungen gemeinsam erörtert werden.

Programm:

10:00 – 10:10 Uhr: Begrüßung

10:10 – 10:40 Uhr: Auf dem Weg zu Linked Open Data – Verbesserung der Qualität von Forschungsdaten zu Objekten materieller Kultur am Beispiel des LIDO-Standards

Julia Rössel (DDK, Bildarchiv Foto Marburg) und Barbara Fichtl (SUB Göttingen)

Im Vortrag werden zum einen das Vorgehen und einige Ergebnisse des BMBF-geförderten Projekts „KONDA – Kontinuierliches Qualitätsmanagement von dynamischen Forschungsdaten zu Objekten der materiellen Kultur unter Nutzung des LIDO-Standards“ vorgestellt, zum anderen wird veranschaulicht, worauf bei der Erzeugung, Verarbeitung und Pflege von Forschungsdaten zu Objekten materieller Kultur zu achten ist, um sie Linked Open Data-fähig zu machen.

10:40 – 11:10 Uhr: Der Census als Linked Open Data – einige Worte zum Arbeitsstand

Kathleen Christian und Franz Engel (HU-Berlin, Census), George Bruseker und Denitsa Nenova (Athen, takin.solutions)

Der Census of Antique Works of Art and Architecture Known in the Renaissance sammelt seit 1946 systematisch visuelle und schriftliche Quellen zur Rezeption von Kunstwerken der Antike in der Renaissance. Bereits 1981 wurden die bis dahin in einem Karteikartensystem gesammelten Daten auf der Grundlage eines relationalen Datenmodells und unter Verwendung der damals verfügbaren Computersysteme digital bereitgestellt. Der Census ist damit eines der wenigen Projekte, an denen sich die Geschichte der Computerisierung und Digitalisierung in den Geisteswissenschaften lückenlos ablesen lässt. Der Census hat sich zum Ziel gesetzt, seine semantischen Linked Open Data-Modelle FAIR zu machen, indem er eine fundierte Dokumentation der Datenmodelle, ihrer Funktion und ihrer Nachnutzungsmöglichkeiten durch Wissenschaftler bereitstellt.

11:15 – 11:45 Uhr: Qualitätsaspekte von Metadaten in generischen Systemen am Beispiel des Projektes „DFG-Viewer für Musikalien“

Andrea Hammes und Sebastian Meyer (SLUB Dresden)

Entwickelt zu Zeiten der beginnenden Massendigitalisierung, ist für den DFG-Viewer nun der Zeitpunkt gekommen, spezifische Anforderungen einzelner Medientypen neu zu denken und das zugrundeliegende Metadatenschema entsprechend anzupassen. Am Beispiel des Projektes „DFG-Viewer für Musikalien“ (ZenMEM der Universität Detmold / Paderborn und SLUB Dresden) sollen derartige spezialisierende Arbeiten an einem im Grundsatz generisch angelegten und breit genutzten System dargestellt und diskutiert werden. Dabei sind sowohl Abstimmungswege für eine solche Anwendung zu berücksichtigen, als auch implizite Folgen und Aufwände in den Blick zu nehmen: Spezifizierungen in gewachsenen Systemen bedeuten immer auch Nacharbeit. Fortdauernde Pflege und Kuratierung auch von Altdaten werden damit zu integralen Bestandteilen der Planung.

11:45 – 12:05 Uhr: Diskussion

– Mittagspause –

12:50 – 13:20 Uhr: Vom Suchen und Finden – Heterogene Datenqualität als Herausforderung im FID Darstellende Kunst

Julia Beck (FID Darstellende Kunst)

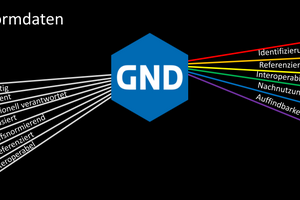

Seit 2015 aggregiert der Fachinformationsdienst Darstellende Kunst Metadaten unterschiedlicher Qualität aus deutschsprachigen Bibliotheken, Archiven und Museen der Darstellenden Kunst, die in verschiedensten Formaten und Standards erfasst werden. Neben Lücken in Normdateien wie der Gemeinsamen Normdatei (GND) sind dabei vor allem die Heterogenität der Artefakte und die flache Modellierung von Entitäten eine Herausforderung. Der Vortrag beleuchtet Aspekte der Datenaggregation wie der Analyse und der Transformation von Metadaten sowie der Aufarbeitung und Neuansetzung von Normdaten, die dazu dienen, Forschenden möglichst strukturierte, durchsuchbare und vernetzte Daten bereitzustellen.

13:20 – 13:50 Uhr: Bereitstellung, Qualität und Aggregation von Korrespondenzmetadaten

Stefan Dumont und Sascha Grabsch (Berlin-Brandenburgische Akademie der Wissenschaft)

Als materialspezifische Informationsinfrastruktur aggregiert correspSearch seit 2014 Korrespondenzmetadaten aus gedruckten und digitalen Editionen sowie anderen wissenschaftlichen Publikationen. Die Daten werden in einem TEI-XML-basierten und mit Normdaten-Identifikatoren versehenen Austauschformat (dem "CMIF") zur Verfügung gestellt – i. d. R. von den Editionen, Trägerinstitutionen und Wissenschaftler:innen selbst. Der Vortrag stellt die bisherigen Erfahrungen von correspSearch mit der Bereitstellung von Daten aus der Community und deren Aggregation vor.

13:55 – 14:25 Uhr: Das Metadatenqualitätsprojekt der DDB – Grundlagen für ein kontinuierliches Qualitätsmanagement

Cosmina Berta und Francesca Schulze (Deutsche Nationalbibliothek)

Die Qualität von Metadaten ist entscheidend für die Funktion und Akzeptanz eines übergreifenden Angebotes wie der Deutschen Digitalen Bibliothek (DDB). Im Kern – damit für die meisten Nutzungsszenarien gleichermaßen – müssen die Metadaten einen schnellen und verlässlichen Suchvorgang im Bestand unterstützen. Zur dauerhaften Verbesserung der Situation sind ganz unterschiedliche Maßnahmen vorstellbar – angefangen von Beratungs- und Vermittlungsangeboten über Analyse- und Reporting-Werkzeuge bis hin zu Verbesserungen aller Verarbeitungsschritte.

14:25 – 14:45 Uhr: Diskussion

14:45 – 15:00 Uhr: Forumsmitteilungen